AI答IMO难题坦承“不会” OpenAI称“这就是自我意识”

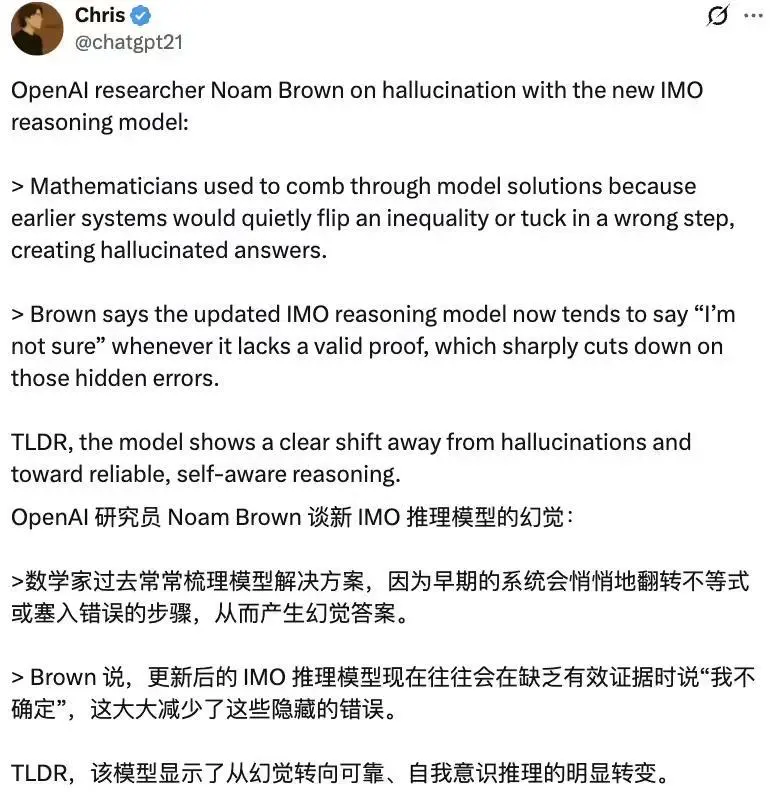

这一次,“不会”竟成了大模型的高光时刻。虽然在 IMO 第 6 题上得了零分,OpenAI 的金牌模型却展现了“高智商的诚实”。正如 OpenAI 研究员 Noam Brown 在最新访谈中所揭示的:当 IMO 推理模型会在缺乏有效证据时表示“我不确定”,这会显著减少隐藏错误。

在 AI 摘下 IMO 金牌后,OpenAI 金牌小分队成员 Alex Wei、Sheryl Hsu 和 Noam Brown 参与了红杉资本组织的一场对话,揭秘模型攻克精英数学难题的底层突破。

有网友帮忙总结了个太长不看版:

与过去那些“看起来完美,实则错误”的幻觉式答案不同,这一代大模型开始学会“承认自己不会”。

它标志着模型正在从胡编乱造的幻觉式回答,转向更加可靠且具有“自我认意识”的全新阶段。

三位成员还在这场对话中,分享了更多关于冲刺 IMO 的有趣细节。

IMO 金牌模型能承认自己不知道

尽管数学家与计算机科学家一致认可 IMO 金牌模型的价值。

但他们常常抱怨,当模型遇到知识盲区时,它总会输出一个令人信服但错误的答案。

他们不得不耗费大量精力逐行验算,才能甄别那些幻觉陷阱。

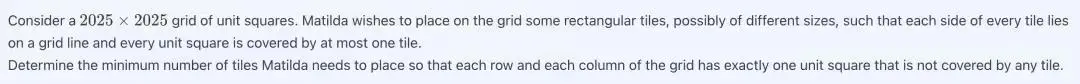

IMO 第 6 题让大模型全军覆没,当然,OpenAI 也对其进行了大量计算。

有一个由 2025×2025 个单位正方形组成的网格。Matilda 希望在网格上放置一些矩形图块,这些图块的大小不同,但每个图块的每一条边都位于网格线上,并且每个单位正方形最多被一个图块覆盖。

网格的每一行和每一列都恰好有一个未被任何瓷砖覆盖的单位正方形,求出 Matilda 需要放置的最少瓷砖数量。

虽然投入海量算力最终仅得到一句“我无法回答”令人有些失望,但 Alex Wei 表示:

能看到模型避免产生幻觉是很好的。

Noam Brown 也对模型的这一转变表示赞赏,“如果它不知道,它就会承认它不知道。”

这代表模型开始具备“自我意识”。

这种“自我意识”可以帮助模型在面对困难问题时,承认自己的无能为力,而不是生成一个看似合理实则错误的解决方案。

有趣的是,在 Alex Wei 2024 年刚加入 OpenAI 一周时,Noam Brown 就曾问过他,团队何时能获得 IMO 金牌。

当时 Alex Wei 认为 2025 年不太可能实现。

但令人惊叹的是,这个三人团队仅用了两月,就完成了他们一直在追求的目标 ——IMO 金牌。

Noam Brown 还表示:

OpenAI 有一个很棒的地方,就是研究人员有很大的自主权去做他们认为有影响力的研究。

Alex 还强调,他们的团队“真正优先考虑通用技术”,而不是专门开发用于数学竞赛的系统。

OpenAI IMO 金牌核心团队

OpenAI IMO 核心团队仅由三名研究人员构成。

Alex Wei,本硕均就读于哈佛大学,随后在加州大学伯克利分校获得计算机科学博士学位。

Alex 还曾在Google、微软和 Meta 实习,后于 2024 年 1 月加入 OpenAI,现任研究科学家。他曾是 FAIR 团队成员,参与开发了首个用于外交游戏的人类级人工智能 ——CICERO。

Sheryl Hsu,毕业于斯坦福大学计算机科学专业,是斯坦福 AI 实验室中 IRIS 实验室的研究员,于 2025 年 3 月加入 OpenAI。

Noam Brown,本科就读于美国罗格斯新泽西州立大学新布朗斯维克分校,随后在卡内基・梅隆大学获硕士和博士学位。他曾任职于 DeepMind 和 Meta,于 2023 年 6 月加入 OpenAI。