人工智能在理解人类行为方面取得了突破性进展。得克萨斯农工大学(Texas A&M University)的研究人员近日开发出一种名为“OmniPredict”的新型人工智能系统,该系统展现出了前所未有的“读心”能力——它不仅能看见人类的动作,更能通过解读视觉和环境线索,实时预判人类的下一步意图。

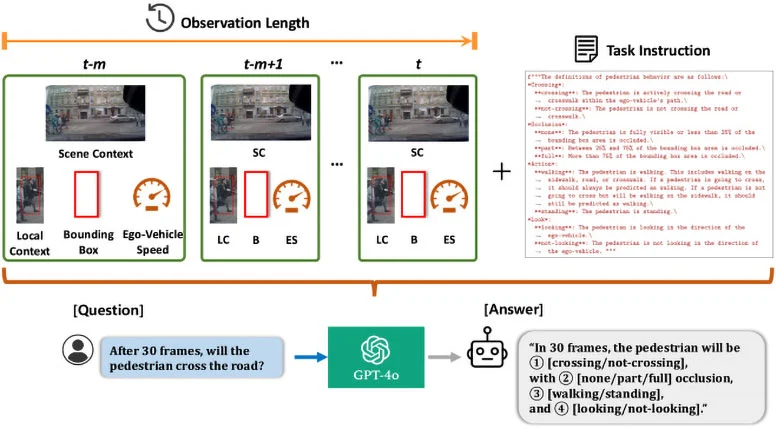

这一研究成果标志着自动驾驶技术从“被动反应”向“主动直觉”的重大跨越。传统的自动驾驶系统通常只能识别行人的当前位置和移动轨迹,而 OmniPredict 则引入了多模态大语言模型(MLLM)技术,使其具备了类似人类的推理能力。该系统能够敏锐地捕捉行人的姿态变化、犹豫瞬间、身体朝向甚至眼神压力等细微信号,从而推断行人究竟是准备过马路、只是在路边等待,还是会有其他突发行为。

研究团队指出,OmniPredict 的核心优势在于它不再仅仅是“看”各种像素点,而是试图理解行为背后的“为什么”。通过分析复杂的混合输入信息,该模型将人类行为精准地归类为穿越马路、视线遮挡、具体动作和注视方向等关键类别。在测试中,OmniPredict 展现了高达67%的预测准确率,比目前市面上最先进的模型高出了整整10个百分点。更令人印象深刻的是,即便在行人被部分遮挡或仅通过眼神与车辆互动的复杂场景下,该系统依然保持了极高的判断稳定性。

项目负责人斯里坎特·萨里帕利(Srikanth Saripalli)博士表示,OmniPredict 赋予了机器一种全新的“街头智慧”(Street Smarts)。如果自动驾驶汽车能够像人类驾驶员一样,读懂路人“欲言又止”的肢体语言并预判其下一步动作,道路交通的安全性将得到质的飞跃。除了自动驾驶领域,这项能够解读肢体语言和心理状态的技术,未来还有望在军事行动及紧急救援等高风险场景中发挥关键作用,通过赋予机器“直觉”,彻底改变人机协作的模式。

编译自/ScitechDaily