今天凌晨,阿里云正式发布了Qwen3系列,一口气开源了从0.6B到235B共8款模型:2个MoE大模型和6个Dense大模型,构成了阿里完整的模型矩阵。这次Qwen3的开源重塑了大模型标准,可以说在“后DeepSeek R1”时代,以阿里为代表的国内大厂,正在借助产品化思维,以性价比和多模态能力全方位抢夺DeepSeek的市场影响力。

Qwen3再一次拉高了世界开源标准

这回阿里云开源的Qwen3,在架构、性能、推理速度和应用方向上均有较大创新和提升。Qwen3系列在模型架构上采用了MoE(混合专家)架构。

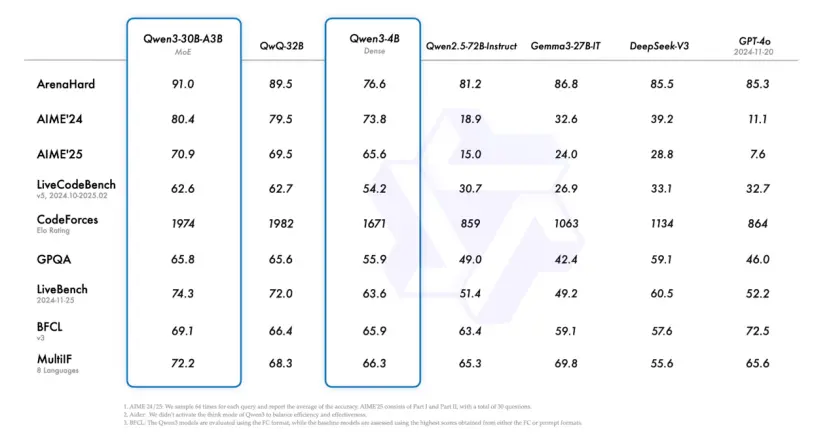

旗舰模型 Qwen3-235B-A22B 拥有约2350亿的总参数量,在每次推理时仅仅激活约220亿参数,性能极其耐打,在综合能力、代码与数学、多语言能力、知识与推理等多项基准测试中,都能与DeepSeek R1、OpenAI o1、o3-mini、Grok 3和GoogleGemini 2.5 Pro等目前市场上的主流大模型相抗衡。

一个亮点是:Qwen3-4B模型凭借极低的参数量,在一系列基准测试中与GPT-4o(2024-11-20版本)打了个有来有回。这体现了阿里在推理效率上的提升并非以牺牲能力为代价。

其轻量化模型Qwen3-30B-A3B和32B,在许多任务上的表现也足够令人满意。

除了基准测试上亮眼的表现外,Qwen3系列这回的一个主要创新特点是:混合思考模式。这种设计让用户能根据任务难度控制模型的推理量:思考模式下,模型能够逐步推理,适合复杂问题,强调深度思考。无思考模式:模型快速响应,适合简单问题,优先速度。难问题用更多推理,简单问题快速解答。

并且,Qwen3为了在国际应用端扩展影响力,已经能够支持119种语言和方言。外网的各国网友对其的评价都很不错,横向对比的话,Qwen3已经追上或者超越了OpenAI o1、GoogleGemini 2.5 Pro。

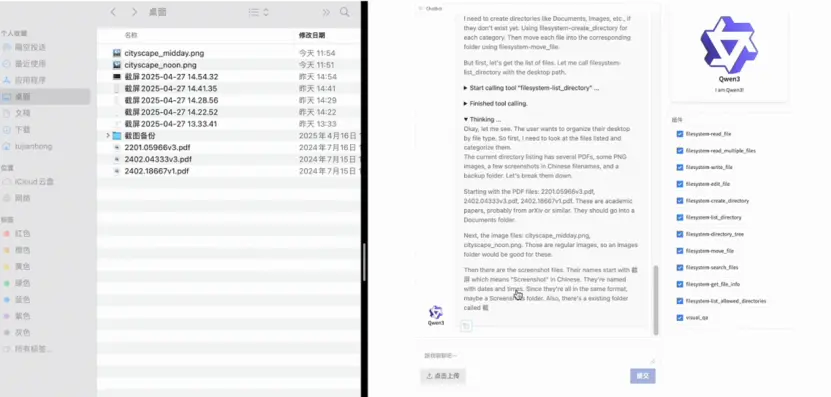

Qwen3还针对最近半年爆火的“AI智能体”概念做出了优化,强调了“智能体”能力。比如它们强化了Qwen3 模型的编码和代理能力,并增强了对 MCP 的支持,让Qwen3 学会如何思考以及如何与环境交互。

在预训练方面,Qwen3 的数据集相比 Qwen2.5 几乎翻了一倍,达到了3.6万亿个token,覆盖了更广泛的领域知识和语境,再度提升了在复杂任务处理和多语言场景中的表现。

这回Qwen3系列的开源,统一采用Apache 2.0开源协议开放权重。通过“小杯-中杯-大杯-超大杯”的产品逻辑构建了一个完整的“Qwen宇宙”。

综合来看,Qwen3 在单纯的技术性能、成本价格、工具调用和MCP调用等所有方面获得了全面的提升,其已经将开源世界的标准提升了一个层次。

DeepSeek光环下的大厂百态

4月25日的2025百度AI开发者大会上,百度创始人李彦宏点名批评DeepSeek“不是万能的,它只能处理单一的文本,不能理解声音、图片、视频等多模态内容。更大的问题是慢和贵,中国市场上绝大多数大模型API的价格都更低,而且反应速度更快。”

他点出了DeepSeek庞大光环下,中国的大厂正在走向用性价比抗衡DeepSeek的现状:用更小参数,更低成本的方式,实现更快的响应,完成不属于DeepSeek的多模态效果。

阿里的Qwen3迅速引入MoE架构和双模式推理设计,将庞大模型在实际使用中的成本大幅降低。凭借DeepSeek R1三分之一的参数量,性能全面超越R1。

首先,Qwen3的MoE架构使得推理过程中仅激活部分专家,从而降低了实际计算开销。例如,Qwen3-235B-A22B虽然总参数达235B,但每个token只需计算其中约9%(22B)的参数。这意味着在相近硬件条件下,其推理延迟并不像参数规模看上去那样高不可攀。

其次,Qwen3的双模式推理设计高效地分配算力。在“非思考模式”下,模型可直接生成答案,实现接近即时的响应;而在需要“思考模式”时,才投入额外计算资源进行多步推理。这种按需分配计算的策略,使模型在大部分简单交互中保持了快速性,又能在关键时刻发挥深度推理能力。

这其实与腾讯的双轨思路相似。2025年2月13日,腾讯元宝接入DeepSeek R1满血版,几天之后就上线了 “强推理深度思考模型”混元T1模型,随即混元团队官宣Turbo S模型上线测试,号称在响应速度上比DeepSeek R1更快。Turbo模型针对日常对话进行优化,弱化长链推理而追求即时回答能力。腾讯内部的AI助手“元宝”应用中,就集成了Turbo快思考和T1深思考两种模型,允许用户在需要详细推理时调用T1,平时默认用Turbo即时回答。

这种双轨策略,与阿里Qwen3单模型双模式有异曲同工之妙,都是为不同复杂度的问题提供差异化模型,既保证效果又保证速度。

DeepSeek R1自从正式上线以来,其幻觉现象频发就成为了各大厂商瞄准的攻坚对象。

百度就是其中的代表。百度在国内大模型竞争中经历了一个明显的策略转折:从最初坚持闭源、寻求商业变现,到在DeepSeek等冲击下宣布开源、全面免费的重大转向。

2025年3月16日,百度如期发布了文心大模型4.5。文心4.5被定义为百度首个“原生多模态”大模型,具备图像、文本、音频等多模态联合理解与生成能力。它引入了深度思考能力,能够进行复杂问题的逐步推理,并集成了百度自研的iRAG检索增强技术。

通过“深度搜索”功能,文心4.5可以自动检索外部知识以回答用户问题,显著降低了幻觉率,这也是百度迎战DeepSeek的底气所在。

在价格方面,百度也正在开始加码。前几天的百度AI开发者大会上发布的文心4.5Turbo,相比于文心4.5价格下降80%,每百万token的输入输出价格仅为DeepSeek V3的40%。DeepSeek的成本优势正在大厂们的面前荡然无存。

字节跳动为了应对DeepSeek的竞争,则将自身的产品重心放在了多模态上。从旗下火山引擎团队于2024年5月首次对外全面介绍了代号“豆包”的大模型家族,一口气亮相了9个模型开始,豆包就着重多模态模型上的发展。

与其他厂商喜欢强调模型参数和基准测试成绩不同,字节刻意淡化参数规模与榜单,转而突出实际落地效果和低使用门槛,力求让大模型真正融入多样化的实际场景。

本月中旬,豆包1.5深度思考模型上线,除了在数学推理、编程竞赛、科学推理等专业领域上表现超越DeepSeek R1之外,最大的亮点是Doubao-1.5-thinking-pro-vision具备了视觉推理理解能力,同时豆包文生图模型3.0版本发布,进一步丰富了多模态生态。

字节跳动的多模态战略背后,是敏锐感知到了大模型从技术概念转向产品概念的路径。后DeepSeek R1时代里,单纯追求参数规模和技术指标的提升已不足以构建产品护城河了。

字节跳动带着这家宇宙大厂的“互联网基因”,加入了大模型竞争。多模型并进确保了其在文本、语音、图像各方面全面开花;极低价格和广泛产品植入为其赢得了规模和数据。

总的来看,除了单纯的专业领域的基准测试刷分之外,价格、响应、多模态都已经成了各大厂商应对DeepSeek竞争的有力武器。当基础语言对话能力很难拉开差距时,各大厂用产品思维找到了迅速突围DeepSeek的差异化功能。

开源生态的长短期利益结合

随着DeepSeek、Llama、Qwen、智谱在开源生态构建上付出了越来越多的努力,开源已经成为主流路线之一。过去大厂倾向于闭源谋利,而如今开源被证明是赢得生态和快速迭代的有效途径。DeepSeek进一步刺激了大厂拥抱开源生态的决心,阿里全面开源千问证明了 “模型开源是AI时代的主题”。

不难看出,国内大模型正走向一个比拼综合实力和效率的时代,而不再仅以参数和单点性能论英雄。

Qwen3、DeepSeek以及腾讯、百度、字节的各种“模型”迭代实践,折射出了一种转变:大家都在追求更高的性价比——既要性能足够好,又要成本足够低、应用足够广。

可以说,我们正在进入AI的下半场。

OpenAI的研究员姚顺雨前段时间曾发长文,探讨AI的下半场该专注于哪里:“从现在开始,AI将从解决问题转向定义问题。为了在‘下半场’蓬勃发展,人们需要及时转变思维方式和技能,更接近产品经理的水平。”

根据晚点访谈,阿里云CTO、通义实验室负责人周靖人对于开源大模型的战略意义:首先,模型作为核心生产要素,开源能加速其普及,推动产业快速发展;其次,开源已成为大模型创新的重要驱动力。

可以预见的是:国内大模型的落地方向将更加贴近实际应用,不再只是实验室里的模型比拼。这也给开源大模型的参数效率、推理成本提供了一个更加激烈的竞争区域。