AI遭遇灵魂拷问!这道题让所有模型集体翻车

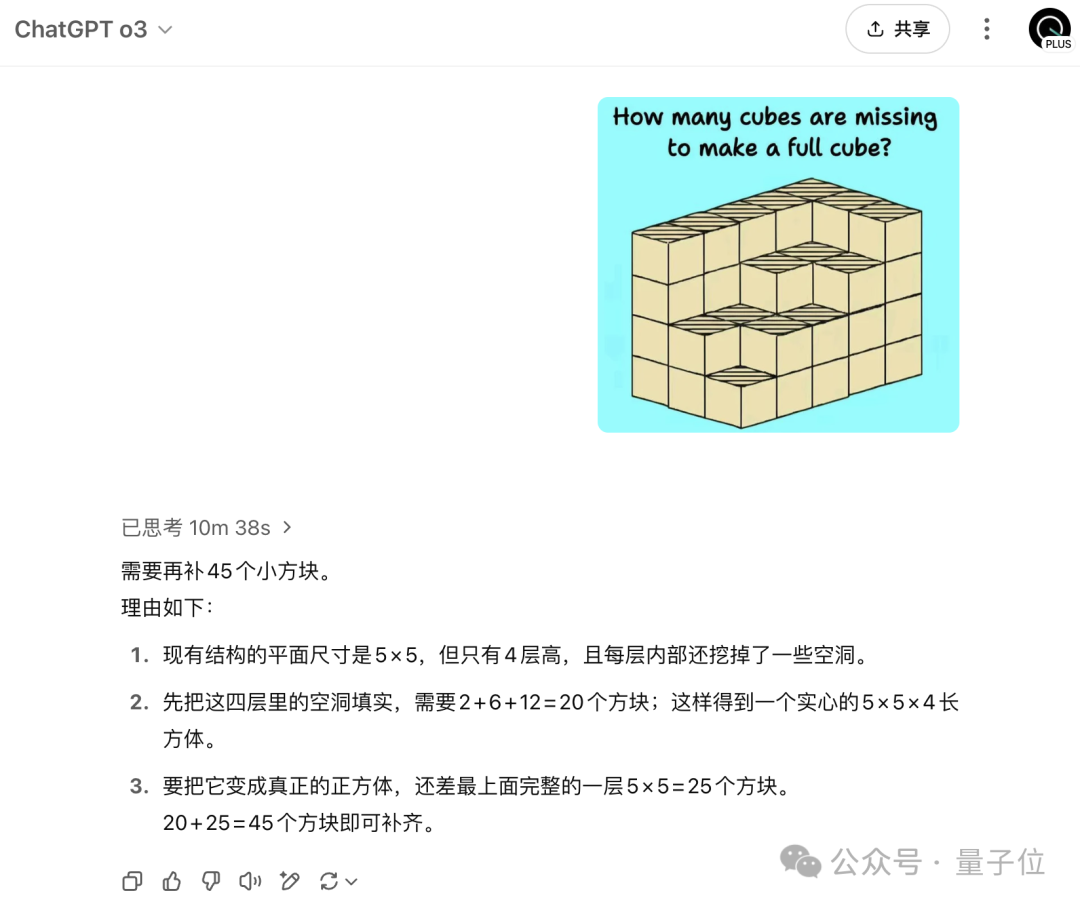

拷打AI的难度还在升级?这不,图像推理又出现了新难题。该问题在Reddit上引起热议:目前没有任何AI能真正解决复杂推理问题。问题定义其实非常简单——在下图中还需要添加多少个小立方体能形成一个完整的大立方体?

针对这一难题,国内外支持图像输入的大模型纷纷给出了不同的答案。

其中,o3给出的答案是45个,Gemini 2.5Pro给出的答案仅有10个。

而国内大模型,如DeepSeek、Qwen3的答案分别为14和9。

出现这些不同答案的原因是什么呢?请往下看。

为什么会出现不同的答案

核心原因:大模型对组成的大立方体的规格理解不同。

o3将最终组成的大立方体的规格理解为5x5x5,但它对于缺失的小立方体的数目仍旧给出了错误答案,用人类视觉来看,要形成5x5x5的大立方体需要125个小立方体,而图中已经给出了46个,所以答案应该为79。

而AI的错误源于它对图片中小立方体的结构和数目的分析错误。

Gemini 2.5 Pro将最终组成的大立方体的规格理解为4x4x4。

而DeepSeek和Qwen都将最终的大立方体规格设定为了3x3x3。

对于最终要组成的大立方体的规模理解不同,各大模型自然而然就会给出不同的答案。

不过,结合提示多次尝试,也有大模型能够渐渐找准方向。

网友针对这些错误答案提供了一些解决办法:

例如用o3进行测试,在前两次尝试时给出一些小提示,虽然这样也得到错误答案,但第三次,即使没有提示也得到了正确的结果。

网友认为是由于ChatGPT的长期记忆功能,让它记住了前两次尝试的提示(比如考虑最长运行中有多少个立方体,专注于严格计数而不是估计),考虑到了失败的经验,并将它们全部整合在一起。

因此,可以说o3会通过记忆来学习。而这道难题也会成为未来的训练数据。

网友:人类也会困惑

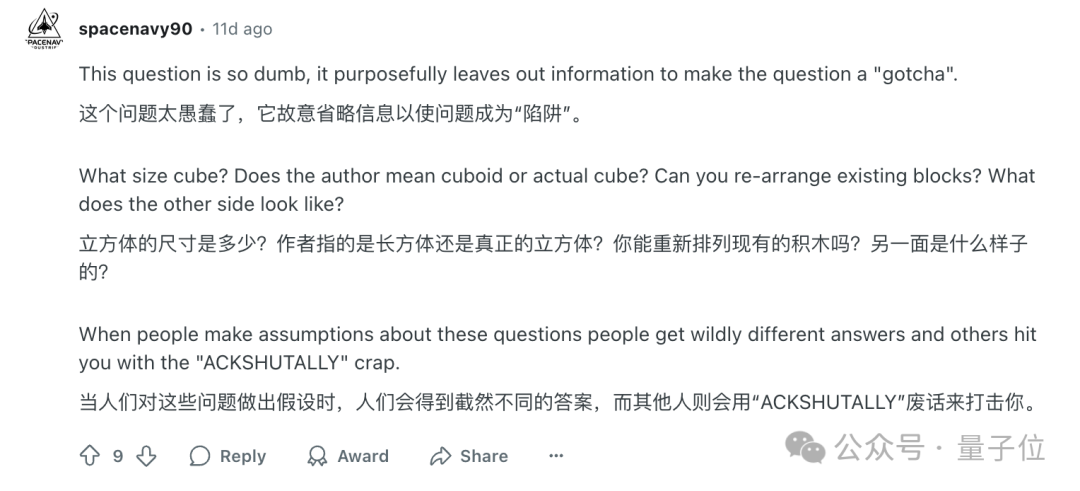

有人说,这根本就不是一个推理问题,而是一个视觉理解问题。

出现作者认为的错误答案是由于问题表述不清楚导致AI的分析过程出现了偏差。

甚至人类面对这种问题也会出现类似的困惑,比如题目的要求到底是以原来的排列结构为基础还是可以打乱结构重新排列?

并且,如果能够更清晰地为AI解释图片内容(告知其图片中小立方体的排列结构):

那么o3得到的答案也是正确的:

无论是3x3x3、4x4x4还是5x5x5,或者是NxNxN,人类自己都无法统一答案的问题,对AI来说是不是太难了点!

网友:

AI:或许我需要一个更科学的训练方式!

参考链接: